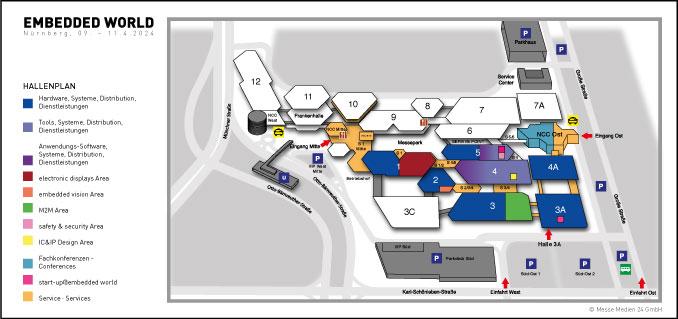

Die TQ Group nutzt für die einlötbaren Module TQMa243xL und TQMa64xxL, das gleiche Grunddesign, um Pin-Kompatibilität über ein weites Leistungsspektrum anbieten zu können. (Bild: TQ Group)

Standards waren und sind ein Erfolgsfaktor für das Embedded-Computing. Sie decken meist sehr gut ein durchschnittliches Anforderungsprofil ab. Bei etwas ungewöhnlicheren Forderungen der Applikation sind sie allerdings oftmals nicht mehr in ihrer Komfortzone. Proprietäre Lösungen, die geschickt die Gemeinsamkeiten von CPU-Familien nutzen, sind hier eine leistungsfähige Alternative.

Das Thema Standards hat im Bereich der Embedded Systeme eine lange Geschichte: So erblickte der VMEbus (Versa Module Eurocard-bus) bereits 1981 das Licht der Welt – und es gibt ihn noch heute. Seitdem hat sich viel verändert und zahlreiche Standards folgten der Marktentwicklung und dem technologischen Fortschritt. Jetzt gibt es mit OSM (Open Standard Module) einen ersten Standard für auflötbare Module – und wie immer gibt es Diskussionen über die Nutzbarkeit.

Standards sind ohne Zweifel notwendig, sie eröffnen für die Anbieter neue Märkte und sind für die Kunden eine Art Richtschnur wie man mit neuen Lösungsansätzen/Technologien umgehen kann. Standards sind daher ein wichtiger Bestandteil der Erfolgsgeschichte des Embedded Computing. Das Wesen der Standards ist es aber „nur“ den Mittelbereich einer Glockenkurve (der Anforderungen) abzudecken. An den Rändern scheitern sie an diversen Faktoren, sei es Preis, Leistungsaufnahme, Performance, EMV-Verträglichkeit oder Schnittstellenauswahl.

Gerade der letztgenannte Punkt ist für viele Kunden der entscheidende Faktor: Fehlt eine notwendige Schnittstelle, dann ist dies das KO-Kriterium. Manche Anbieter von Modulen, wie die TQ Group, reagieren daher mit der Strategie „Jedes nutzbare Signal eines Prozessors muss vom Modul herunter geführt werden!“

Hier spielt die CPU-Architektur eine entscheidende Rolle. Bei der x86-Architektur ist die Schnittstellensituation überschaubar, da die vom Markt gewünschte Rückwärtskompatibilität Änderungen nur sehr langsam aufnimmt. Auch wollen nur die wenigsten x86-Kunden etwas anderes als einen PC mit einem gewissen „Embedded-Extra“ haben. Die davon abgeleiteten Embedded-Standards spiegeln das entsprechend wider und ergänzenden die reine PC-Funktionalität um Embedded-Schnittstellen und -Funktionen.

Bei der Arm-Architektur ergibt sich ein anderes Bild: Hier sind die Chips oftmals auf eine spezifische Anwendung hin optimiert, man spricht auch von applikationsspezifischen Prozessoren (ASSP). Das schließt häufig die Nutzung für andere Anwendungen aus. So sind beispielsweise die CAN-Schnittstellen eines „Automations-Chips“ für Smartphones völlig uninteressant. Hier für einen (Modul-)Standard eine gemeinsame Schnittmenge zu finden, ist sehr schwer – zu viele Schnittstellen und Funktionen könnten oder müssten auf der Strecke bleiben.

Auf der anderen Seite ist die Aussicht mit jedem neuen Prozessor das Rad (Pinout) wieder neu erfinden zu müssen, auch keine angenehme Situation für Anbieter von Embedded-Modulen. Es gibt aber einen Ausweg: Man sichert die Pin-Kompatibilität bzw. Austauschbarkeit der Module innerhalb einer Bausteinfamilie. Dies ist die konsequente Fortführung einer Strategie, die bereits seit geraumer Zeit von Halbleiterherstellern verfolgt wird. Besonders Anbieter von Arm basierten MCUs und CPUs nutzt das Potenzial der unterschiedlichen Arm-Cores, um eine sehr weite Skalierbarkeit in den Bereichen Rechenleistung, Funktionalität und Preis bereitstellen zu können. Ein Beispiel liefert Texas Instruments mit den Familien Sitara Am243x und Am64x: Erstere sind als Mikrocontroller klassifiziert und verfügen zwischen einem oder zwei Arm Cortex R5F-Cores in Begleitung mit einem M4-Core. Die Am64x gelten als Mikroprozessoren die über bis zu zwei Cortex A53-, bis zu vier R5F- und einen M4-Core verfügen. Da beide Bausteinfamilien Pin-kompatibel zueinander sind, kann TQ mit einem gemeinsamen Grunddesign die zwei Modul-Familien TQMa243xL und TQMa64xxL anbieten, die Pin-Kompatibel zueinander sind und ein sehr weites Performance-Spektrum abdecken.

Eine oftmals unterschätze Herausforderung für einen Architektur- und Hersteller-übergreifenden Modul-Standard kommt mit der Heterogenität der Signalqualität einer Schnittstelle: Nicht jedes Standard-Signal z.B. Ethernet, hat bei jedem Halbleiterhersteller und jeder Bausteinserie die gleiche Qualität und verlangt daher nach unterschiedlichem Aufwand für das Träger-Board. Anbieter von proprietären Modulstandards haben es leichter das Pinout ihrer Module für ein Signal zu optimieren – das vereinfacht für Kunden die Entwicklung eigener Träger-Boards erheblich.

Ein weiteres wichtiges Argument für Modul-Standards ist der Second-Source-Gedanke: Gibt es Probleme mit einem Lieferanten, kann auf einen anderen gewechselt werden. Die letzte Allokationsphase hat allerdings schmerzhaft gezeigt, dass wenn ein Anbieter nicht mehr liefern kann, die Situation beim anderen Lieferanten auch nicht besser ist. Der Second-Source-Gedanke hilft also nicht kurzfristig bei der Beschaffung, sondern ist eher als Absicherung gegenüber dem Totalausfall eines Lieferanten wegen Firmenpleite, Embargos oder ähnlichem geeignet.

Modul-Nutzer die gezielt auf Pin- und Softwarekompatibilität von CPU-Familien setzen, können damit einen „Hausstandard“ definieren, der ihren Bedürfnissen besser entsprechen kann, als ein durch Gremien standardisiertes Konzept. Abhängig von der Applikation bedeutet das: Entweder es wird die Komfortzone eines Standards getroffen oder die Anforderungen verlangen klar nach einer proprietären Lösung. Betrachtet man die Embedded-Computing-Geschichte, dann kann man wohl auch nur ein zeitlich begrenztes Optimum finden, denn sonst hätten sich nicht so viele Standards in den letzten 43 Jahren entwickelt. Embedded-Standards haben ihre Berechtigung – gleichberechtigt neben proprietären Lösungen.

Autor:

Andreas Willig

Produktmanager

TQ-Systems GmbH

www.tq-group.com